“中国做CDN难在带宽成本太高,BAT有可能在这方面颠覆;阿里提供的是标准化服务,但CDN服务需要全球化、分时段、个性化”

5月27日,蓝汛科技(ChinaCache )首席执行官、董事长及联合创始人,国内最早的CDN玩家王松接受了财新记者专访。作为中国CDN市场两大垄断寡头之一,王松解读了中国CDN市场发展,并对比中美CDN市场发展,分析了BAT等玩家进场的逻辑。

“在美国,CDN已经被证明是一个百分百赢家通吃的市场。”王松指出,但中国市场由于底层宽带网络被运营商垄断,CDN服务公司的受限于宽带成本,并非高毛利的行业。王松告诉财新记者,和互联网行业已经追平甚至赶超美国同行不同,中国的CDN行业落后于美国同行七八年时间。

这次互联网公司高调进入市场,王松态度乐观:“阿里云的高调进入对于整合行业的认知度和市场培育有积极作用。”但在他看来,阿里云等提供的服务多为标准化服务,而CDN网络只有实现全球跨区域、分时段、个性化的服务才能让资源最有效配置。

在这样的背景下,王松称看不到中国的CDN市场会形成“赢家通吃”的趋势。

财新记者:我们要怎么理解CDN(内容分发服务)?作为基础服务,CDN服务有什么特点或者说有什么门槛?

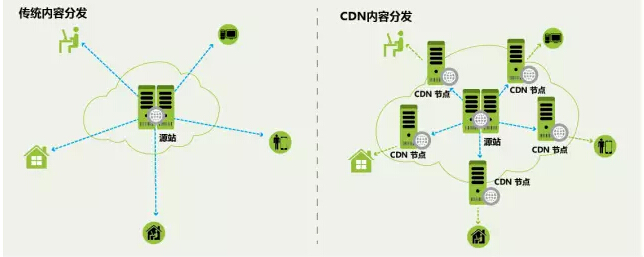

王松:CDN我们可以理解为云分发服务,目前的云服务分为云计算、云存储、和云分发。互联网要提供商业服务,这三者缺一不可。云计算是生产,云存储像仓库,云分发是物流,这就是互联网产业的形态。

对于CDN,云分发平台而言,门槛一个是平台能不能支持,二是在平台上面能否快速开发出应用。平台打好之后,你要在上面快速地建出房子。

其实在美国市场,已经证明了CDN是一个百分百赢者通吃的领域。而且,CDN绝对应该是全球性的业务,不是区域性的业务。当然中国经常会颠覆这一结论,可能中国的市场的确比美国大。在美国除了Akamai一家CDN公司其余都赔钱。对于CDN企业来说,它的网络规模越大,企业优势就更加明显。因为CDN会有时间复用、客户量复用,还有更重要的是区域复用。

比如北京现在是白天,而美国是晚上,通过全球调度就可以降低使用成本。某巨型国际客户就和我们合作,利用北京的夜间流量支持美国西海岸的日常服务,这样资源可以24小时地利用起来。当然不同的业务需求也不同。有的业务可能非常敏感,跨境服务可能就有问题,比如网购、游戏。有的业务不那么敏感,就可以选择跨境来支持。

财新记者:您刚才提到美国的CDN市场,能否跟我们分享一下CDN业务在美国是如何发展的?

王松:中国的CDN产业发展比美国晚7到8年,美国CDN领域已经经历了至少三轮的发展。从表面上看中国各个种类的公司发展都很快,但是做底层业务的公司并不多。比如美国第一轮互联网泡沫的时候,Akamai的泡沫是最大的,短短两年就经历了过山车式的增长和下跌。

但与此同时,第一轮互联网泡沫也带动了后端企业的发展,比如做CDN的Akamai,做存储的NetApp,还有一大批类似的公司。所以美国第一轮互联网发展出现许多做底层业务的公司,包括数据中心。第二轮是做视频的内容分发,YouTube等企业就此发展起来了;所以美国在每一轮互联网高峰的时候都有很多基础的公司起来。而在中国,我们是第一个CDN行业在美国上市的公司,但比美国整整晚了十年。中国整个CDN产业跟美国有很大的差距。比如我们得到的一个数据,2013年美国骨干网中一半的流量是CDN的流量。现在美国做CDN的公司很多,各种各样的模式都在出现,CDN领域的垂直和细分越来越明显。

财新记者:中国的产业发展情况呢?中国的CDN市场最终怎么就只剩下蓝汛和网宿两家巨头?我们和美国差七八年的原因是什么?

王松:在中国CDN企业生存非常难,最核心的问题是带宽成本高。CDN服务中50-60%的成本是带宽成本,而对于Akamai来说这个比例是15%。为什么美国视频领域能够发展出YouTube?当然有谷歌支持的因素,但是它的带宽成本远远低于我们的成本。

财新记者:中国市场上现在有一种声音,认为商用CDN市场发展前景有限,你怎么看商用CDN和自建CDN在中国的趋势?

王松:自建和商用永远不是非此即彼的关系,选择自建还是商用主要根据公司自身业务的发展,考虑哪种方式更有效率。比如对于物流领域,足够大的公司可能会考虑自建物流体系,认为这种方式更具效率。也有些产业随着发展越来越成熟,专业化分工也更加明显。比如汽车行业发展前期,汽车制造公司从头到尾都自己制造。而发展到现在,轮胎、发动机、玻璃等等都委托给别人做。除非他认为这个是非常核心的业务,否则都会交给第三方来做。

财新记者:你怎么看待阿里加速布局CDN领域这件事情?阿里云高调宣布下调CDN价格,你最开始知道这件事时是什么感受?

王松:其实阿里云布局CDN市场,我觉得是在模仿亚马逊的做法。亚马逊最早提供CDN服务的时候,它的主要业务就是云计算(EC2)、云存储(S3)、云分发(CloudFront)这三块业务。亚马逊发展早期有四分之一到三分之一的收入来自这一部门。大型的云服务商都会把CDN当作一个服务去提供,微软的Windows Azure在美国也跟第三方合作来提供CDN服务。把CDN服务和云计算服务打包提供给客户的话,这是全球一个典型的模式。

我刚听到阿里云CDN降价的时候,并没有太大的反应。但是股票市场对这件事非常紧张,我才认识到大家对这个事情的认知并不太一样。在CDN的普及率还很低的情况下,阿里云进入这个市场并参与市场竞争,对提高行业认知度来说是很好的事。另外,阿里云提供CDN服务可以培育许多小的客户,使他们建立使用CDN的习惯,我觉得从长远来说是帮我们培养大中型客户。当客户的业务逐渐发展起来,就需要更专业更大规模的CDN提供商来获得更高质量的服务。

阿里云做CDN服务相比目前的主营业务投资回报效率并不高。首先,CDN领域并非高毛利的业务,仅30%左右,跟互联网企业动辄60%甚至70%的毛利率相比算是比较低的。也就是说100元钱阿里云投入到主营业务中有60元的回报,但放在CDN行业里仅仅30%的回报。从投资角度来说肯定是不划算的。

这和亚马逊做CDN不一样,亚马逊是个位数的毛利,它对成本控制非常严格,因此有投资CDN领域的动力。

财新记者:所以您认为CDN不会成为BAT真正会去布局的核心业务?

王松:阿里的云平台和淘宝平台到现在实际上还没有完全融合,在这个层面跟我们新平台相比还是落后的。但是阿里有淘宝这样一个特殊应用,所以他们在电商的配套服务上面的理解肯定比我们要深得多。针对电商的应用来说,应该有很多独到之处。所以他们这部分的分发是基于自己提供的服务和定制化但是对于一个电商行业,它的网络究竟该按照什么标准来构建,这是一个需要理清的问题。如果按照每年流量的高峰来建它的网络,一年中大部分时间都会出现空闲,造成浪费;如果按照日常的使用量来建起网络,高峰时的使用就成了一个问题。但是它又希望建立一个很大的平台,所以选择了按照高峰来建立网络,而把富余的流量拿出来开放使用。但是这样也有一个问题,阿里巴巴的平台要优先满足自己的业务,那在双十一这样的流量高峰时,它该兼顾哪边呢?

互联网公司做CDN,客户群会受到限制。现在阿里云的客户都是小型的客户,这些客户做大了之后肯定会面临一个问题:CDN服务、数据中心的服务要求这个服务提供者本应是中立的第三方,但是BAT这三家基本每个行业都涉及,所以跟他相关的行业可以说风险巨大,这就是CDN产业面临的非常现实的问题。但是BAT进入CDN这个领域,对这个行业来说是个好事,尤其对于初创公司,可以帮他们真正把门槛降低。

财新记者:大客户这方面有没有感到直面的来自BAT的竞争?你们担心阿里云这样的互联网公司来做蓝汛现有的业务服务么?

王松:直面的竞争没有,潜在的竞争有的。我们的CDN业务主要服务大型的企业。但是行业发展到现在,CDN业务越来越普及,这个市场对大家来说是个蓝海,全新的市场。未来新兴的互联网公司和小型企业可能是我们跟BAT竞争的市场。另一个方面,我们对每个行业的了解积累会有帮助,比如银行业,我们把某国有银行做好了,以后这个行业的其他客户我们也都能做好了。

未来的竞争是要看谁把这块成本做得更低。看在所有的环节里,谁能把哪个环节的成本去掉。

阿里巴巴最大的问题是节点都在一线城市。早期的调度可能要放在核心的网络环境好的位置,而现在越分散到二三线城市,成本越低。就好像把北京的蔬菜卖给顺义的人吃,顺义的人肯定觉得你比我们当地的价格还高,所以他们对于成本还是没有那么敏感。

互联网公司真想做个商业化的CDN,还有很长的路要走。就这种成本控制、接下来还想着怎么把夜里的空闲量用上,因为他们的用户模型是非常单一的。

财新记者:运营商也说布局CDN领域,你怎么看?

王松:全世界运营商都试图在做这一领域。现在互联网不是最简单的技术问题,而是快速地迭代更新能力。比如说运营商要建立一个平台,昨天还是微博,今天大家就都用微信了,它该怎样适应这种模式呢?

财新记者:传统CDN企业是不是也在布局云服务,包括存储运算?往底层走?移动互联网方面我们有什么新布局?

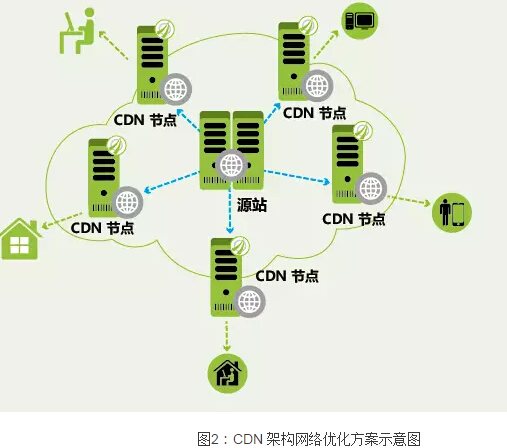

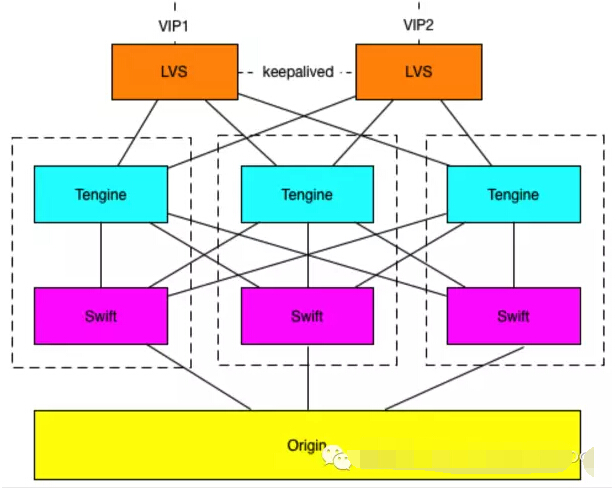

王松:其实CDN最早就是做规模化的云计算的服务,当然云计算的层次不太一样。早期是一个PAAS层面的云计算服务。我们也在不断地演进,去年开始推出新的HPCC平台上线,实现完全云化。从底层的平台到存储、前端全部都是一个平台,可以实现全网在一个平台来调度。HPCC平台服务于蓝汛ChinaCache的页面加速、文件分发下载、视频流媒体、移动互联网等核心业务,降低客户资源成本、大幅提升用户体验。更灵活的缓存模式及更快速的应变能力, 全面提升各项性能指标。

我们已经投资建设了蓝汛首鸣云数据中心,是中国第一个这种规模的数据中心。其实今天在中国还没有一个真正意义的互联网交换中心。工信部今年增加了7个交换中心,还停留在让三家运营商做互联互通的层面。其实在美国已经到了第二步,叫内容交换,前面只是网络交换。

网络交换仅是网络流量进行交换,同样一个内容一百个人就需要一百次交换;内容交换只需要一次网络交换,以后再访问的时候就不需要流量交换。

今天在中国网络交换还没完成,内容层面就更没有。我们跟西安交大正在建立研发中心,在学校周边做配套升级。西安交大出基础设施,我们出所有的技术来进行合作。所以接下来会在西安交大建立西北五省的交换中心,小的运营商、内容商都可以在那交换。美国所有大的内容商都会把自己的内容尽量放在交换中去,小企业就不需要通过网络被大的运营商绑架,从而大幅降低成本。我们的带宽成本降不下来,因为我们没有第三方的交换中心。

移动互联网方面,蓝汛于今年初发布了专门针对移动互联网的产品MPlus,该解决方案是面向移动互联网终端用户、内容提供商的B2B2C商务模式与访问加速技术的综合解决方案,帮助企业获得高于正常基础60%的通信速率,并开创性地具备了减免终端用户无线流量费用的特性,为移动互联网内容提供商业务推广与终端用户体验提升提供了更多空间。

财新记者:CDN最后会赢家通吃吗?

王松:看吧,现阶段还没有这个趋势。